Música e información (1): una introducción al cruce entre arte y ciencia

En el corazón del quehacer musical y de la filosofía de la música late una pregunta tan antigua como fascinante: ¿por qué ciertos sonidos organizados nos conmueven, nos estructuran o nos hacen pensar? A menudo entendida como una expresión sólo estética o emocional (forma de verla profundamente reforzada desde el período romántico), la música también puede abordarse desde una perspectiva estructural y científica. Este enfoque se vuelve particularmente fértil cuando se la analiza desdeuna teoría que todavía no llega a tener cien años: la teoría de la información, una rama de las ciencias duras que tradicionalmente se ha aplicado a campos como la informática, la comunicación y la biología, pero que desde hace décadas ha comenzado a dialogar también con las artes

La motivación para escribir este artículo surge de mi propia experiencia al investigar para, redactar y defender mi tesina para recibirme de licenciado en composición. En el caso de que el texto a continuación despierte interés, podremos continuar con entradas al blog relacionadas a este tema.

El presente texto propone una introducción al cruce entre música e información, partiendo de la intuición de que las obras musicales no solo expresan emociones, sino que codifican, transforman y transmiten estructuras de información. Para explorar esta idea, nos apoyaremos en el pensamiento de tres autores muy importantes: Claude Shannon, Meyer Leonard, y Pierre Schaeffer, cuyas obras han sentado bases teóricas y prácticas para pensar la música más allá del ámbito puramente sensorial o expresivo.

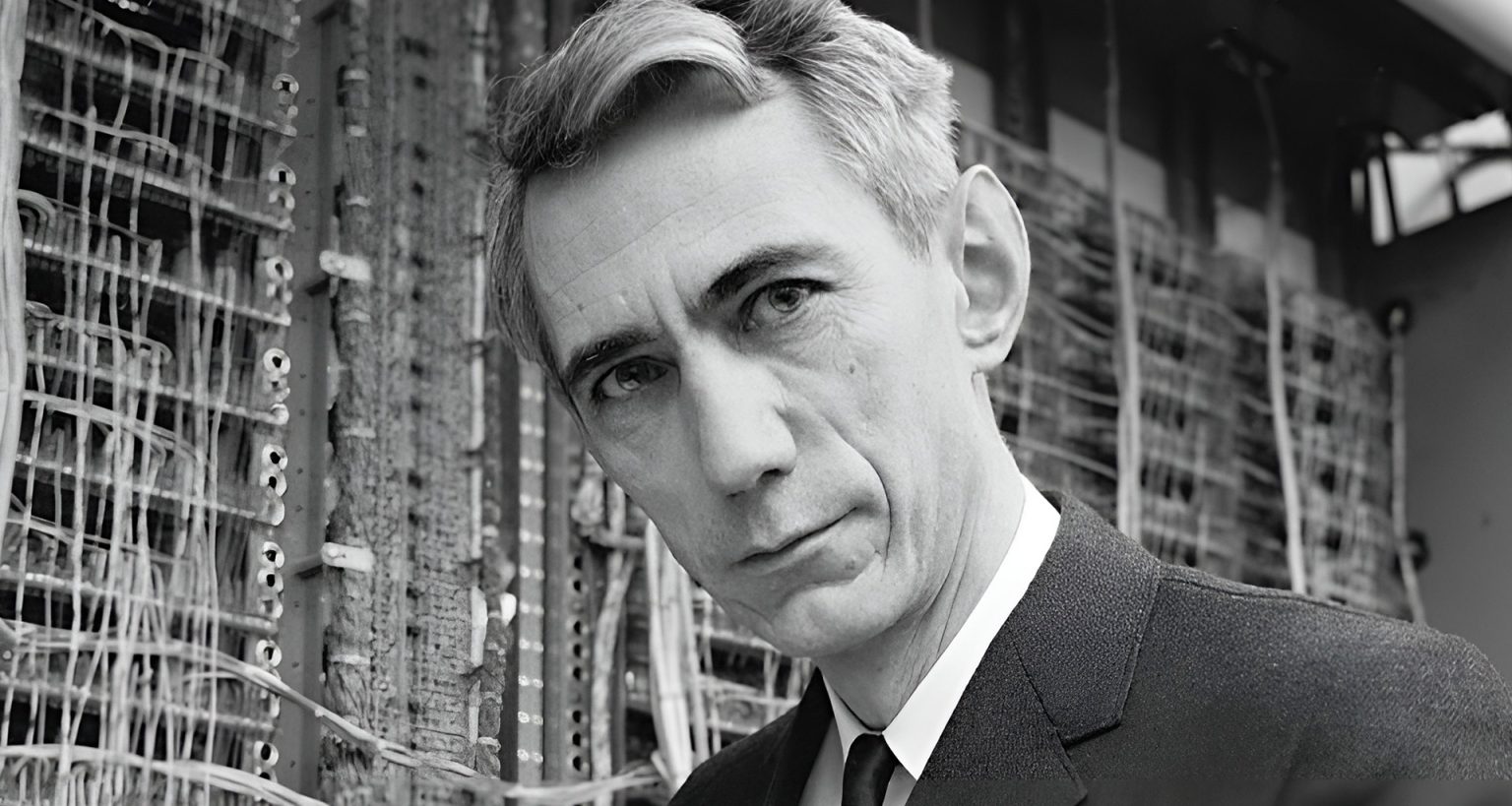

Claude Shannon y el concepto de entropía musical

En 1948, el ingeniero y matemático Claude Shannon publicó su influyente artículo "A Mathematical Theory of Communication", donde presentó una formalización matemática de la información. Su teoría estaba pensada para resolver problemas de codificación y transmisión en canales de comunicación, como los teléfonos o las señales de radio. Pero su noción de entropía informacional resultó aplicable a muchos otros dominios, incluyendo la música.

Shannon definió la entropía como una medida de incertidumbre o aleatoriedad: cuanto más impredecible es una secuencia de símbolos, mayor es su entropía. Al aplicar este concepto a la música, podemos entender una obra como una sucesión de eventos (notas, silencios, timbres) que puede ser más o menos predecible. Un patrón muy repetitivo tiene baja entropía, mientras que una música atonal o fuertemente improvisada puede tener alta entropía.

Esta perspectiva permite formular preguntas nuevas: ¿cuánta información se transmite en una pieza de Bach comparada con una improvisación de jazz? ¿Cómo varía la entropía entre estilos musicales? ¿Podemos pensar la composición musical como una estrategia para gestionar el equilibrio entre redundancia (previsibilidad) y novedad (sorpresa)? La teoría de Shannon no busca explicar el sentido emocional de la música, pero ofrece herramientas para analizarla como un sistema de transmisión simbólica.

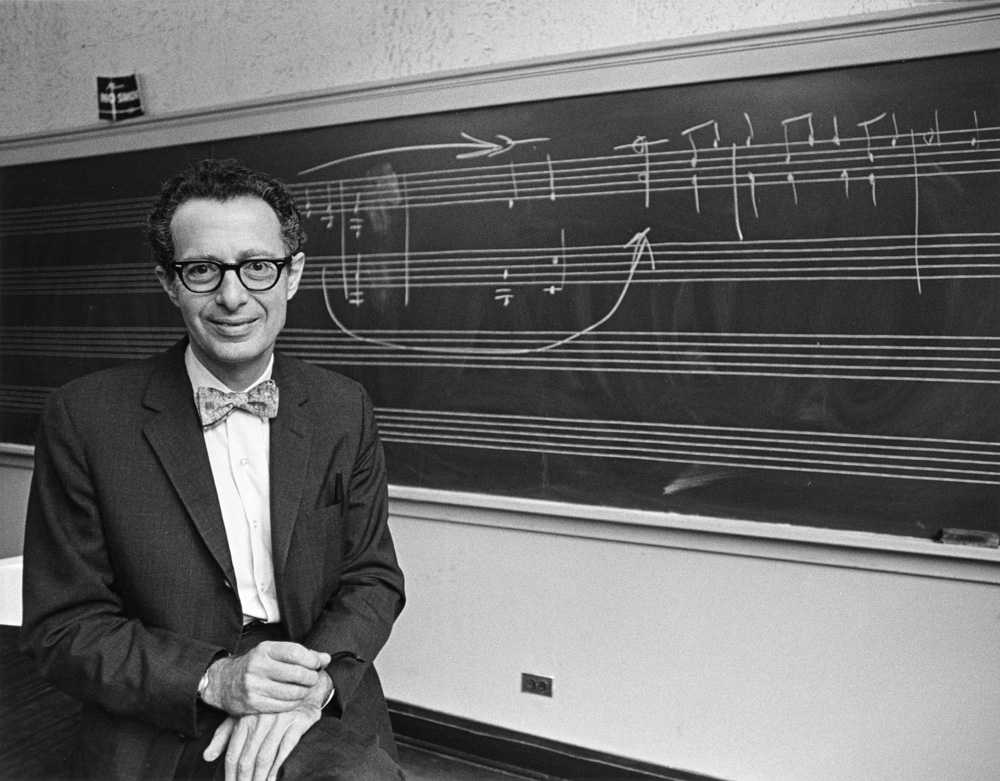

Leonard B. Meyer: emoción e incertidumbre

El musicólogo y filósofo Leonard B. Meyer retomó estas ideas en su libro "Emotion and Meaning in Music" (1956), donde aplicó directamente conceptos de la teoría de la información a la experiencia musical. Para Meyer, la emoción que sentimos al escuchar música está profundamente ligada a nuestras expectativas. La música, según él, se basa en convenciones estilísticas que el oyente internaliza; cuando esas convenciones se cumplen o se rompen, se genera una respuesta emocional.

Meyer utilizó el concepto de entropía para explicar esta dinámica. Una música muy predecible genera aburrimiento, y una completamente impredecible puede resultar caótica o incomprensible. El equilibrio entre ambos extremos produce tensión y resolución, sorpresa y confirmación: elementos fundamentales para la experiencia estética musical. La música, en esta visión, se convierte en una forma altamente refinada de gestión de expectativas.

Así, desde Meyer, no solo entendemos que la música transmite información, sino que la manipulación de esa información está íntimamente ligada al surgimiento de la emoción. La obra musical, entonces, no solo comunica "algo" sino que lo hace gestionando el grado de incertidumbre del oyente. Esta idea ha influido profundamente en análisis musicales contemporáneos, en neurociencia de la percepción musical, e incluso en estudios sobre inteligencia artificial aplicada a la composición.

Pierre Schaeffer y la escucha reducida

Desde otra tradición –más cercana a la música concreta y a la experimentación sonora del siglo XX–, el francés Pierre Schaeffer propuso un enfoque fenomenológico del sonido que también puede entenderse en clave informacional. En su obra "Traité des objets musicaux" (1966), Schaeffer propone la idea de "objeto sonoro" como unidad mínima de escucha, despegada de su fuente física o función semántica. La llamada écoute réduite (escucha reducida) consiste en concentrarse únicamente en las propiedades acústicas de un sonido: su timbre, duración, dinámica, textura.

Aunque Schaeffer no emplea directamente los términos de Shannon o Meyer, su planteo invita a pensar la música como organización de información acústica, donde cada objeto sonoro es una unidad significativa por su estructura interna y su contexto. Desde este enfoque, el análisis musical puede orientarse a cómo se codifica y transforma la materia sonora, y no solo a cómo se organiza en función de escalas o armonías tradicionales.

Además, el trabajo de Schaeffer tiene fuertes implicancias para las prácticas de sampling, diseño sonoro, música acusmática y arte sonoro contemporáneo. En todos estos casos, la música se construye a partir de unidades mínimas de información sonora que son recontextualizadas y reorganizadas en estructuras complejas.

Ciencia y arte: la resolución de un intervalo mal entendido disonante

La intersección entre música e información no es simplemente una metáfora. Implica un cambio de paradigma en cómo comprendemos la música: ya no solo como una forma de expresión sensible, sino también como un sistema estructurado de relaciones, códigos, transformaciones y operaciones. Esta mirada no reemplaza a la visión tradicional de la música como arte, sino que la enriquece con herramientas para pensar, analizar, componer y escuchar de nuevas maneras.

Además, el diálogo con la teoría de la información abre la puerta a preguntas que cruzan disciplinas: ¿puede una inteligencia artificial componer música emocionalmente significativa? ¿Cómo se diferencia el procesamiento musical en el cerebro humano respecto de un sistema computacional? ¿Qué papel juega la música en la organización simbólica de una sociedad?

También nos lleva a revisar prácticas pedagógicas. Enseñar música desde una perspectiva informacional permite trabajar la estructura, la forma, la percepción y el análisis de una manera rigurosa pero no necesariamente árida. La música deja de ser un simple arte interpretativo o emocional para convertirse también en un sistema de pensamiento.

A modo de semi-cadencia

Este artículo apenas roza la superficie de un campo vasto y en expansión. A través de Shannon, Meyer y Schaeffer, hemos presentado tres entradas posibles a la relación entre música e información. Pero el camino es mucho más amplio, y atraviesa hoy disciplinas como la musicología computacional, la neurociencia, la inteligencia artificial, la teoría de sistemas, y las prácticas artísticas contemporáneas.

Pensar la música como información no significa reducirla a un conjunto de datos, sino descubrir en ella una forma compleja y viva de organizar el mundo. En esa organización se juegan tensiones entre orden y caos, entre expectativa y sorpresa, entre sonido y significado. Tal vez, como en todo lenguaje profundo, la música no solo nos dice algo: nos enseña a pensar.